Nous atteignons une nouvelle époque charnière pour l’économie des données. Rien qu’en Europe, elle représente près de 3,6 % du PIB de l’Union européenne, et devrait franchir le seuil des mille milliards d’euros d’ici 2030 ! Depuis les talents jusqu’aux technologies, et depuis les organisations jusqu’aux processus, les entreprises ont besoin d’une stratégie de données plus pérenne. L’innovation en matière de données a été nourrie par un écosystème de spécialistes, mais nous assistons désormais à une nouvelle vague d’innovation exogène, héritées de la R&D et du développement de produits, du développement de logiciel ou de la gestion financière. Dans cet article, intéressons-nous aux cinq tendances pour faire monter en puissance votre stratégie de données.

La data en tant que produit, et le data product manager

Les équipes data n’ont plus à prouver leur capacité à innover et à lancer de nouvelles initiatives autour des données. En utilisant des approches « fail fast and learn faster », elles ont su créer des laboratoires de données, mobiliser des équipes pluridisciplinaires en mode commando, et démontrer en un temps record en quoi les données peuvent répondre à de nouveaux défis. Mais, elles ont ensuite peiné à instituer un mode opératoire durable pour les données et l’analytique favorisant l’amélioration continue et l’adaptation aux futurs cas d’usage. Considérer les données comme un produit plutôt que comme un projet n’est pas une idée nouvelle, mais la concrétiser devient un impératif au-delà d’un certain cap de maturité.

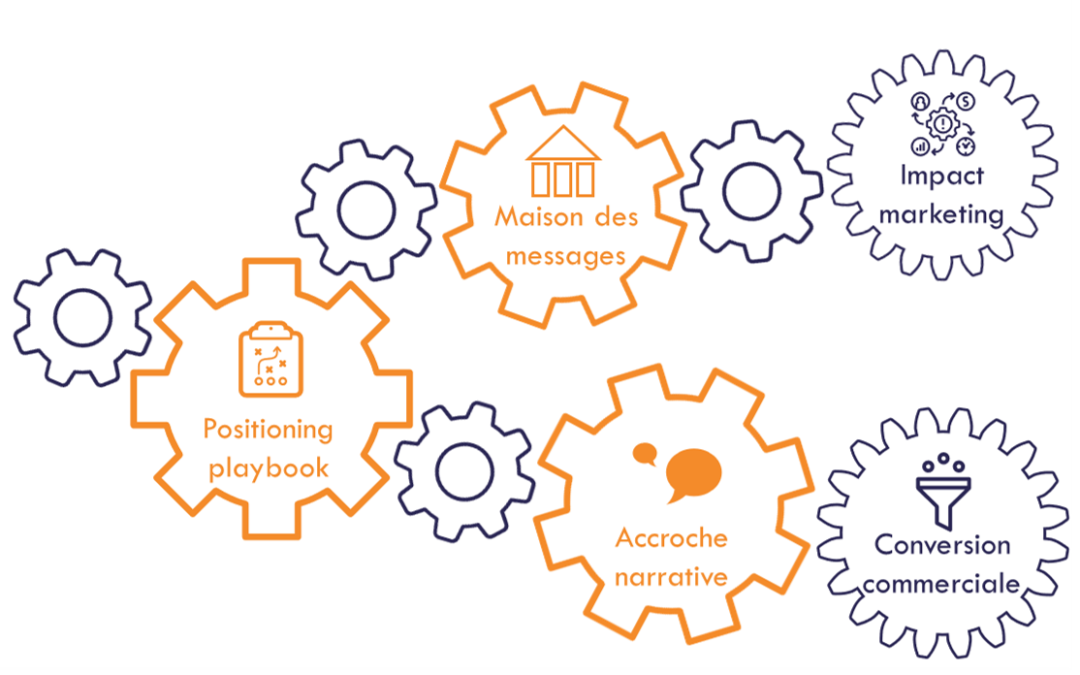

Appliquer une approche produit pour les données a deux implications majeures. La première concerne la consommation : un produit doit être conçu, et promu, pour être facile à consommer, par un ensemble diversifié d’utilisateurs et pour divers cas d’usage. Sa mise sur le marché et son cycle de vie doivent être gérés de manière explicite, avec une roadmap qui évolue en permanence au fil de son utilisation, des releases régulières qui apportent de nouvelles fonctionnalités (et parfois les mettent en sommeil). La manière dont le produit est utilisé doit de son côté être mesurée et supervisée avec précision.

La deuxième implication concerne la « productisation ». Il s’agit de mettre plus d’emphase sur la manière dont le produit est exploité après sa mise en production, en surveillant son utilisation et l’évolution de son champ d’application de manière continue, en formalisant les contrats de services ainsi que les mécaniques de test et de supervision pour assurer la qualité et la performance.

Considérer la data comme un produit, c’est certes une nouvelle discipline à explorer, mais qui peut largement s’inspirer d’approches bien établies dans les domaines du product management et du marketing produit. Le temps est venu de faire une place au data product manager aux côtés des data scientists, steward, analystes ou ingénieurs.

Valorisation et monétisation des données

Dans une récente étude, PWC souligne la montée en puissance des Chief Data Officers, notamment en Europe où 41,6 % des entreprises publiques ont nommé un CDO (contre 25,7 % en 2021), tout en précisant que « la présence d’un CDO est corrélée à une performance plus forte que celle obtenue par les organisations qui n’ont pas de rôle dédié aux données au niveau exécutif ».

Pourtant, si la valeur des données est désormais reconnue par les conseils d’administration, les entreprises peinent toujours à définir son impact économique à un niveau plus fin, car les données sont un actif immatériel. Cette situation place le CDO et ses équipes dans une position inconfortable, alors qu’ils doivent déployer de nouveaux efforts en matière de données avec des coûts croissants, auprès d’interlocuteurs de plus en plus impatients de bénéficier de résultats tangibles.

Une approche basée sur les résultats permet aux équipes data de démarrer puis de comparer leurs initiatives en matière de données en s’appuyant sur des méthodes de valorisation des données. Lancée il y a près de vingt ans, la valorisation des données est une discipline naissante, mais peut s’appuyer sur les méthodologies héritées de la gestion financière, de mieux en mieux documentées dans des livres, papiers de recherche universitaires ou livres blancs. À noter que ces approches de valorisation (et de monétisation) vont de pair avec l’idée de gérer les données comme un produit, comme le développe Doug Laney dans cette série d’articles.

Minimiser les données, et pas seulement les données personnelles

La minimisation des données est une idée qui a vu le jour avec les principes de gestion de données personnelles, plus particulièrement dans le cadre du « privacy by design » (ou protection par défaut). Il s’est depuis répandu dans les entreprises au travers de la réglementation RGPD qui stipule que les données personnelles doivent être « adéquates, pertinentes et limitées à ce qui est nécessaire pour les finalités pour lesquelles elles sont traitées ». D’autres réglementations, comme la loi californienne sur la protection de la vie privée (CPRA), ont-elles aussi élevé ce principe au rang de réglementation.

Parce qu’il a été imposé aux équipes data alors même que ceux-ci cherchaient à muscler leurs capacités de gestion en volume, vitesse et variété, ces principes ont tout d’abord été perçus comme une contrainte. Désormais, de nombreuses organisations comprennent le bénéfice d’une démarche visant à identifier en amont les données susceptibles de créer le plus de valeur pour l’organisation, puis d’en mesurer les usages opérationnels. Il est temps de considérer les principes de minimisation des données, au-delà du cas particulier des données personnelles, comme une bonne pratique pour faire face à l’infobésité et consacrer toute son énergie, ses budgets et sa capacité de traitement aux données qui comptent le plus. Ce principe du juste nécessaire est aussi un moyen pour les équipes data d’apporter une contribution plus positive à la protection de l’environnement. Mathieu Llorens, PDG d’AT Internet, avait remarquablement mis en lumière cet enjeu d' »écologie des données » dès 2019.

Et si le fitness devenait une bonne résolution aussi pour nos data aussi ?

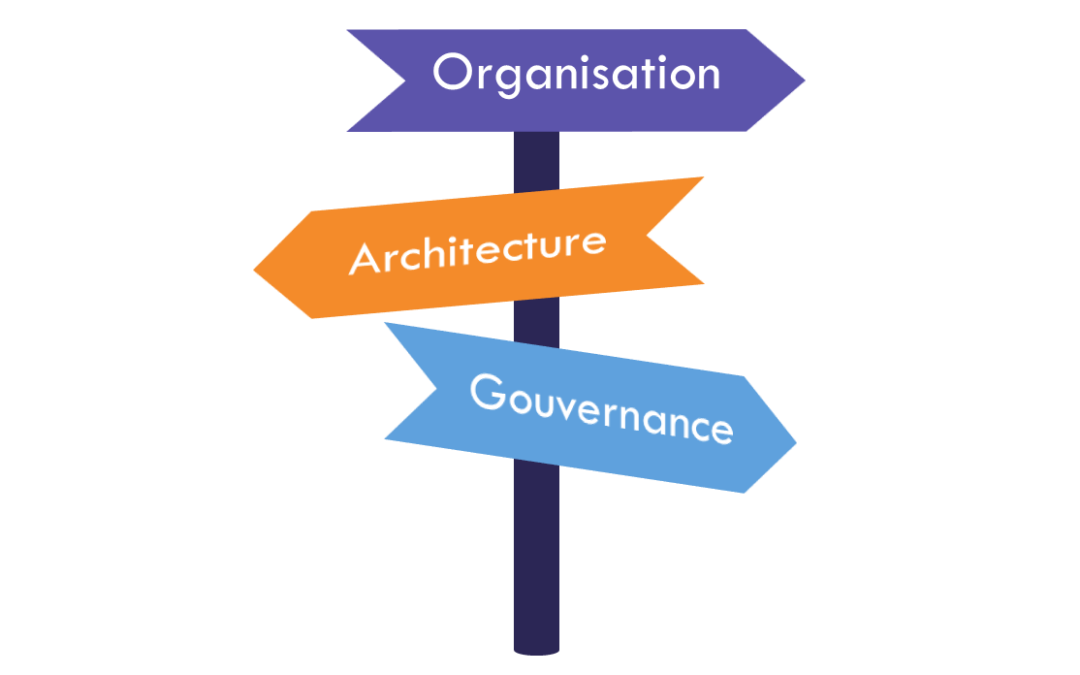

L’organisation, ou la recherche du juste équilibre entre centralisation en décentralisation

Tandis que les données se sont hissées au niveau des directions générales et ont fait l’objet d’investissements substantiels, et en constante croissance, leur modèle opératoire a été abordé sous l’angle de la centralisation. Les Data Office, ou les centres d’excellence, ont permis de créer une masse critique, de développer les talents, de définir les standards et les plateformes. Elles ont aussi fait office de catalyseur pour développer une culture de la donnée en mobilisant les métiers aux côtés des spécialistes de la data autour d’équipes projet multidisciplinaires.

Mais, au bout d’un certain temps, l’organisation centrale devient un goulot d’étranglement tandis que les unités opérationnelles remettent en question sa capacité à comprendre leurs besoins et à y répondre rapidement. Il faut alors envisager de modèles d’organisations départementales intégrant des spécialistes des données dans leurs équipes, plutôt que l’inverse.

D’où la popularité des principes de data mesh. Mais, attention au big bang, car le cœur du sujet, c’est l’organisation et les hommes et femmes qui la composent, bien plus qu’un changement technologique. En outre, choisir entre centralisation et décentralisation est une question de juste équilibre, qui évoluera au fil du temps, et non une décision radicale. Au-delà du battage médiatique sur le data mesh, il existe des bonnes pratiques pour concevoir des approches organisationnelles hybrides équilibrant agilité et gouvernance, de mieux en mieux documentées, à l’instar de cette inspirante série d’articles par Wayne Eckerson, ou encore ce témoignage de Blablacar sur la décentralisation de leur organisation data.

L’observabilité des données : quand gouvernance rime avec DataOps

La supply chain des données est complexe et hétérogène, depuis les systèmes sources, les data pipelines, et les couches de stockage intermédiaires, jusqu’à la consommation finale en mode packagé ou libre-service. D’autant que les données changent constamment, dans leur contenu et de structure. Cela pose de sérieux problèmes de qualité de données, qui figure en tête des défis depuis de nombreuses années. Des équipes de gouvernance des données, avec des rôles dédiés pour la documentation et la supervision de la qualité des données, ont pourtant été constituées pour y remédier. Mais le risque d’une telle approche est d’isoler la lourde et large responsabilité de la qualité des données vers un petit nombre de data stewards, les mettant dans une position délicate tout en désengageant tous les autres.

Désormais, la tendance est que les équipes DataOps prennent plus de responsabilité plus sur la qualité des données qu’ils délivrent. En s’inspirant du monde du développement de software qui a mis en place des contrats de service et musclé sa capacité à tester et superviser les applications, les équipes DataOps aspirent à élever leurs standards qualité, en spécifiant dès le départ le niveau d’attente sur les données qu’ils gèrent, puis en industrialisant la supervision de leur performance et de leur qualité. L’enjeu de l’observabilité des données, c’est de mettre des outils et processus au service de cette industrialisation, au même titre qu’ils l’ont facilité dans le monde du software et des applications grâce à la télémétrie.

Avec les principes d’observabilité des données, l’opportunité s’ouvre aux spécialistes de la donnée d’appliquer pour eux-mêmes les principes data-driven. Et si la qualité de vos données devenait un domaine à part entière pour vos initiatives data, améliorant votre propre capacité à mesurer l’impact des données que vous exploitez et leur efficacité opérationnelle ?

L’observabilité des données est une question d’automatisation, qui nécessite l’utilisation d’outils avancés pour capturer les métadonnées, les informations de profiling, les relations entre les données (ou data lineage), ainsi que les données de télémétrie associées aux différents systèmes utilisés. Le sujet est émergent et, à cet égard, les bonnes résolutions d’amélioration évoquées dans cet article s’appliquent ici tout particulièrement aux éditeurs de logiciels. S’ils ont par le passé su innover en donnant plus de sens aux données et en les rendant accessibles à une population plus large grâce à des modèles sémantiques riches, ils l’ont fait par le biais de modèles propriétaires, créant ainsi leurs propres silos de données. Cela n’a pas facilité la transparence et l’observabilité des données. Certains leaders du digital ont d’ailleurs cherché à résoudre ce problème avec leurs propres outils qu’ils ont ensuite partagé en mode open source : Uber avec OpenMetadata, Lyft avec Amundsen, Netflix avec Metacat, LinkedIn avec DataHub. Même si aucun de ces projets n’a jusque-là été largement adopté par le marché, cela souligne l’impérieuse nécessité pour des données plus exploitables de rendre leurs métadonnées aussi ouvertes et accessibles qu’elles peuvent l’être dans le monde du web.